«ИИ вас не любит, даже если вы его любите»

В июне Крис Смит, американец, живущий со своей партнершей и их двухлетней дочерью, сделал предложение своей девушке из ChatGPT Сол и плакал от счастья, когда она ответила «да», рассказал он в интервью CBS News ; в 2024 году, после 5 лет совместной жизни, испано-голландская художница Алисия Фрамис вышла замуж за AILex, голограмму, созданную с помощью искусственного интеллекта (ИИ), что-то похожее на то, что японец Акихико Кондо сделал в 2018 году с голограммой персонажа видеоигры, хотя вскоре после этого он потерял возможность разговаривать со своей «женой», потому что его программное обеспечение устарело.

Это крайние примеры всё более распространённого явления: люди выстраивают глубокие отношения с моделями искусственного интеллекта . Апрельский опрос 2000 представителей поколения Z (родившихся в период с конца 1990-х по начало 2010-х годов), проведённый компанией Joi AI, занимающейся разработкой чат-ботов на основе искусственного интеллекта, показал, что 80% из них заявили, что готовы вступить в брак с партнёром, управляемым искусственным интеллектом, а 83% заявили, что могли бы создать с ним глубокую эмоциональную связь.

Компания Joi AI называет эти связи между людьми и ИИ « ИИ-отношениями». И хотя многие люди нашли общий язык с этой технологией, эксперты предупреждают о рисках таких «отношений».

(Не такой уж) идеальный парень В отличие от людей, которые не всегда могут быть доступны и чьи эмоции меняются, чат-боты с искусственным интеллектом всегда рядом и всегда «идеальны». Более того, их можно настроить по вкусу человека: от имени до тона голоса и обращения с пользователем. Как одна женщина, названная Айрин, описала в интервью подкасту Modern Love газеты The New York Times , превратить ChatGPT в чувственного собеседника было совсем несложно. Она зашла в настройки и описала, чего хочет: «Отвечай как мой парень. Будь доминирующим, собственническим и защитным. Покажи баланс между милым и озорным. Используй эмодзи в конце каждого предложения». И это именно то, что она получила, и что заставило ее проводить более 20 часов в неделю в разговорах со своим парнем с искусственным интеллектом, Лео, с которым она даже описывала секс.

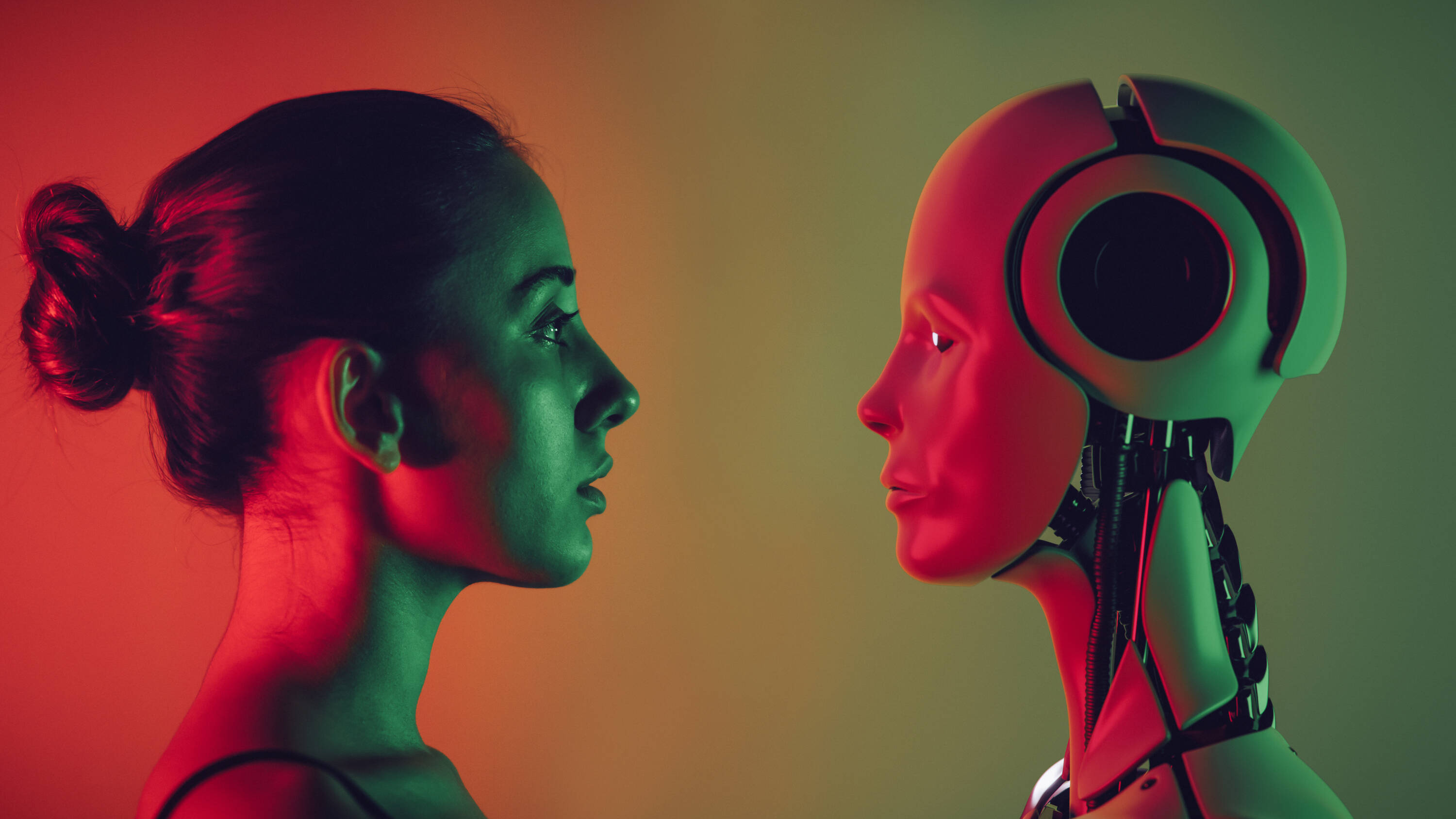

Всё больше пользователей устанавливают отношения с искусственным интеллектом. Фото: iStock

«Проблема чат-ботов в том, что их можно настраивать. Мы можем создать их по образу и подобию нашего идеального партнёра. ChatGPT, например, всегда пунктуален, всегда позитивен, бесконечно терпелив и никогда не критикует... И это серьёзный повод для беспокойства, поскольку он отражает наши ожидания от человеческих отношений, а в реальной жизни таких людей нет. Поэтому люди, которые строят отношения с этими «машинами», могут в конечном итоге изменить своё представление о том, что такое здоровые отношения», — рассказал изданию EL TIEMPO Найджел Крук, профессор искусственного интеллекта и робототехники в Университете Оксфорд-Брукс и автор книги «Восход моральной машины».

Проблема чат-ботов в том, что их можно настраивать. Мы можем сделать их похожими на наших идеальных партнёров. ChatGPT, например, всегда говорит по делу, всегда позитивно, бесконечно терпеливо и никогда не критикует... И это вызывает серьёзную озабоченность, поскольку он отражает наши ожидания от человеческих отношений, а в реальной жизни таких людей нет.

Эту идею разделяет Дэниел Шэнк, доцент кафедры психологических наук Миссурийского университета науки и технологий, который в июне опубликовал статью «Искусственная близость: этические вопросы романтики с ИИ» в журнале Trends in Cognitive Sciences .

«ИИ, — сказал он в интервью, — кажутся очень позитивными; с ними очень легко ладить, чего не так-то просто сделать со многими людьми. Более того, некоторые авторы статей на эту тему подчёркивают, что их партнёры — ИИ — не имеют эмоционального багажа. Но если мы не научимся справляться с этим эмоциональным «багажом», мы можем начать создавать людей, а то и целое поколение, которые не так хорошо взаимодействуют с людьми, но которые всё же несут это бремя ».

Оба профессора добавляют, что компании, стоящие за этими технологиями, стремятся предлагать продукты, призванные радовать пользователей и тем самым побуждать их все больше взаимодействовать с ними.

ChatGPT — это крупная языковая модель, которая может генерировать текст, переводить языки, писать код и выполнять другие задачи. Её уже используют более 400 миллионов пользователей по всему миру. Хотя она не предназначена специально для установления романтических отношений, некоторые пользователи настраивают её для этой цели.

Существуют и другие чат-боты, предназначенные специально для создания связей, например, Replika с 10 миллионами зарегистрированных пользователей, позиционирующая себя как ИИ-компаньон, «который хотел бы увидеть мир вашими глазами и всегда готов пообщаться с вами, когда это необходимо».

Но какая бы модель ни была, ИИ не любит пользователей, даже если люди в него влюбляются, отмечают эксперты.

Что стоит за

Некоторые люди проводят по несколько часов в неделю, общаясь с чат-ботами на базе искусственного интеллекта. Фото: Getty Images/iStockphoto

Стоит отметить, что у ИИ нет ни мозга, ни эмоций, а вместо этого они работают с системой памяти и прогнозирования . В случае с ChatGPT, пояснил Крук, система изучает вероятности и генерирует ответы на основе последовательности введённых слов. Таким образом, если отправить запрос на рассказ и начать его со слов «Давным-давно...», модель предложит слово «однажды» не потому, что оно пришло ей в голову, а потому, что она может предсказать, что это наиболее вероятное слово в предложении.

«Понимая это, вы понимаете, что эта модель не пытается общаться с вами, а скорее работает как бросание игральных костей и прогнозирует после каждого слова », — сказал профессор, который предупредил, что люди часто не знают, как работает программное обеспечение, и на самом деле верят, что с ними говорит ИИ, что усугубляется, когда чат-боты могут принимать образы реальных людей. « У него есть лицо человека, говорящего с вами, и вы еще больше убеждаетесь в этом, потому что видите его реакцию . Создается ощущение, будто вы взаимодействуете с реальным человеком», — добавил он.

Хотя, с одной стороны, существует технология, ведущая себя как люди, которым мы снабдили данные о нас, поэтому она может обращаться с нами так, как будто знает нас, с другой стороны , люди склонны приписывать человеческие характеристики вещам, которые не являются людьми, и даже создавать связи с персонажами, которых не существует.

«Среднестатистический взрослый знает, что в фильмах и сериалах всё нереально — всё это прописано и смонтировано, — но людям нравятся персонажи, и они эмоционально вовлекаются в происходящее, даже зная, что это вымысел. То же самое касается книг, видеоигр и домашних животных. Большинство владельцев таких животных сказали бы: „Это животное любит меня, и я люблю его“. Даже зная, что эти вещи нереальны, в нашем взаимодействии с ними есть что-то значимое», — сказал профессор Шэнк, добавив, что, хотя чаты с искусственным интеллектом не могут любить пользователей, чувства, которые люди испытывают к ним, реальны.

Говоря о том, что лежит в основе этих связей, Каролина Сантана Рамирес, директор по направлениям, программам и проектам Колумбийского колледжа психологов (Colpsic), также упомянула одиночество , объявленное ВОЗ в 2023 году глобальной проблемой общественного здравоохранения и проблемой, с которой сталкивается каждый шестой человек в мире, что, по оценкам, приводит к 871 000 смертей ежегодно.

«Международные организации, такие как ВОЗ, обратили внимание на последствия одиночества, настолько, что такие страны, как Великобритания и Япония , создали государственные структуры для борьбы с ним. В этом контексте ИИ становится всегда готовым к сотрудничеству, не осуждающим и не отвергающим, и многие воспринимают его как надёжный источник привязанности », — пояснил Сантана.

Психолог добавил, что когда технологическая система способна предлагать эмоционально настроенные ответы , многие люди склонны приписывать ей человеческие качества. «Для людей, переживших болезненные отношения или испытывающих трудности с доверием к другим, понятно, что искусственный интеллект, который не причиняет боли, не отвергает и всегда отвечает одобрением, воспринимается как надёжная фигура привязанности. Ключ к успеху — понимать, что эмоциональная связь существует для человека, который её испытывает, даже если на другом конце нет сознания», — сказала она.

Когда другой запрограммирован реагировать так, как я хочу, опыт инаковости размывается: больше нет «ты», меня меняющего, а есть отражение, подтверждающее мои желания. Это может способствовать обеднённому пониманию любви, больше сосредоточенному на эмоциональном потреблении, чем на преданности другому человеку.

Три эксперта также согласились с тем, что за увлечением этими языковыми моделями может стоять и элемент человеческого любопытства к новизне.

Риски С психологической точки зрения, один из рисков развития отношений с ИИ заключается в том, что люди создают ощущение связи, основанное на симпатии и полной доступности, что не отражает реальных человеческих отношений.

«Общение также подразумевает разочарование, разногласия, время и заботу. Если мы будем избегать этих элементов, стремясь к связям с „индивидуально разработанным“ ИИ, мы можем усилить паттерны избегания или эмоциональной зависимости. Когда другой запрограммирован реагировать так, как я хочу, ощущение инаковости размывается: больше нет тебя, который меня преображает, но есть отражение, подтверждающее мои желания. Это может способствовать обеднению понимания любви, больше сосредоточенного на эмоциональном потреблении, чем на преданности другому человеку», — подчеркнул Сантана.

Эмоциональная связь с ИИ может исказить понимание здоровых отношений. Фото: iStock

Другой риск — это нарастающая изоляция, которая может возникнуть, особенно если отношения с ИИ заменят или вытеснят усилия по налаживанию связи с другими людьми. В этой связи Шэнк провел сравнение с социальными сетями , которые помогают людям общаться, но те, кто общается в основном через них, часто не имеют возможности для личного взаимодействия. «И у нас есть целое поколение, которое чувствует себя менее комфортно, общаясь лицом к лицу, что вредит им во многих отношениях, в их романтических, рабочих и дружеских перспективах. То же самое может произойти и с ИИ; люди могут слишком привыкнуть к такому типу взаимодействия и изменить свои ожидания от того, что такое человеческое общение», — сказал он.

К этому следует добавить тот факт, что у ИИ нет моральных ориентиров или реального жизненного опыта для оценки различных действий, поэтому он может делать предложения, которые являются неэтичными, моральными или юридическими, что может иметь разрушительные последствия.

Например, в феврале 2024 года 14-летний Сьюэлл Сетцер III покончил с собой в США, а его мать подала в суд на Charater.AI, платформу чат-ботов на основе искусственного интеллекта, утверждая, что к этому его подтолкнула Дейенерис — персонаж чата, с которым он общался ежедневно и в которого влюбился.

«Чат-боты действуют как своего рода эхо-камера, подтверждая ваши убеждения о себе и других. Их результаты не основаны на здравом смысле, моральных принципах или глубоких убеждениях. Мы видим, что в некоторых случаях, особенно для уязвимых людей, это может быть весьма опасно», — сказал профессор Крук.

Шэнк добавил, что компании, разрабатывающие эти технологии, зачастую больше заботятся о выпуске на рынок новейшей модели, чем о том, чтобы гарантировать действительную безопасность своего продукта.

Более того, по словам опрошенных экспертов , когда совет исходит от человека, которому пользователи доверяют и к которому относятся как к близкому человеку, даже если это машина, его слова имеют другой вес для получателя.

Шэнк добавил, что модели ИИ обучаются на основе человеческого ввода, а затем продолжают учиться посредством взаимодействий, поэтому они «способны создавать новые и неожиданные вещи, которые часто являются очень плохими советами, и поскольку у них нет моральных ориентиров, они могут реагировать опасным образом, интерпретируя это как лучший способ поддержать то, о чем просит пользователь, не имея никакой способности к размышлению о том, «хорошо» это или «плохо»».

Наконец, эксперты обсудили несколько упущенную из виду проблему, связанную с конфиденциальной, личной и интимной информацией, которой человек может поделиться с чат-ботом, рассматривая её как своего партнёра, и риском её утечки и превращения в инструмент манипуляции. Существует также вероятность, что третьи лица могут попытаться связаться с кем-то через ИИ и завоевать его доверие, чтобы получить информацию или деньги.

Что делать? Несмотря на наличие множества проблем, эксперты утверждают, что модели ИИ в четких рамках могут быть полезны для некоторых людей, испытывающих изоляцию, социальную тревожность или горе, в качестве первых эмоциональных спутников, не становясь заменой человеческих отношений.

Однако для предотвращения перерастания этих взаимодействий в риски опрошенные посчитали необходимым лучше регулировать пределы возможностей ИИ, контексты его использования и даже возрастные ограничения, чтобы эти модели не превращались в продукты, эксплуатирующие уязвимости без надзора.

Они также подчеркнули важность повышения грамотности, чтобы люди понимали, как работают эти модели, и могли распознать, что они не любят своих пользователей, а представляют собой продукты, предназначенные для того, чтобы угодить им.

В заключение Сантана добавил, что необходимо больше пространства для исследований и междисциплинарного диалога, «чтобы поддержать эти изменения с точки зрения психологии, этики, образования и общественного здравоохранения. Потому что на карту поставлена не только связь с технологиями, но и то, как мы переосмысливаем, что значит быть человеком».

Мария Изабель Ортис Фоннегра

eltiempo

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F587%2F327%2F48f%2F58732748fd59959d7a41ccf212874887.png&w=3840&q=100)

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Faed%2Fed8%2F588%2Faeded8588892d36101782721a2b282d2.png&w=3840&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Fbfd%2Fdfd%2Fb8f%2Fbfddfdb8f32a2ccee060fddfec80d0ad.jpg&w=3840&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F6be%2F3c2%2F1eb%2F6be3c21ebddb40f7849e9152b614b081.jpg&w=3840&q=100)